谷歌搜索引擎優(yōu)化 (SEO)創(chuàng)建并提交 robots.txt 文件

您可以使用 robots.txt 文件控制抓取工具可以訪問(wèn)您網(wǎng)站上的哪些文件。robots.txt 文件應(yīng)位于網(wǎng)站的根目錄下。因此,對(duì)于網(wǎng)站 www.example.com,robots.txt 文件的路徑應(yīng)為 www.example.com/robots.txt。robots.txt 是一種遵循漫游器排除標(biāo)準(zhǔn)的純文本文件,由一條或多條規(guī)則組成。每條規(guī)則可禁止或允許特定抓取工具抓取相應(yīng)網(wǎng)站的指定文件路徑下的文件。除非您在 robots.txt 文件中另行指定,否則所有文件均隱式允許抓取。

下面是一個(gè)包含兩條規(guī)則的簡(jiǎn)單 robots.txt 文件:

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: http://www.example.com/sitemap.xml

以下是該 robots.txt 文件的含義:

1、名為 Googlebot 的用戶代理不能抓取任何以 http://example.com/nogooglebot/ 開(kāi)頭的網(wǎng)址。

2、其他所有用戶代理均可抓取整個(gè)網(wǎng)站。不指定這條規(guī)則也無(wú)妨,結(jié)果是一樣的;默認(rèn)行為是用戶代理可以抓取整個(gè)網(wǎng)站。

3、該網(wǎng)站的站點(diǎn)地圖文件路徑為 http://www.example.com/sitemap.xml。

如需查看更多示例,請(qǐng)參閱語(yǔ)法部分。

創(chuàng)建 robots.txt 文件的基本準(zhǔn)則

要?jiǎng)?chuàng)建 robots.txt 文件并使其在一般情況下具備可訪問(wèn)性和實(shí)用性,需要完成 4 個(gè)步驟:

1、創(chuàng)建一個(gè)名為 robots.txt 的文件。

2、向 robots.txt 文件添加規(guī)則。

3、將 robots.txt 文件上傳到您的網(wǎng)站。

4、測(cè)試 robots.txt 文件。

創(chuàng)建 robots.txt 文件

您幾乎可以使用任意文本編輯器創(chuàng)建 robots.txt 文件。例如,Notepad、TextEdit、vi 和 emacs 可用來(lái)創(chuàng)建有效的 robots.txt 文件。請(qǐng)勿使用文字處理軟件,因?yàn)榇祟?lèi)軟件通常會(huì)將文件保存為專(zhuān)有格式,且可能會(huì)向文件中添加非預(yù)期的字符(如彎引號(hào)),這樣可能會(huì)給抓取工具帶來(lái)問(wèn)題。如果保存文件時(shí)出現(xiàn)相應(yīng)系統(tǒng)提示,請(qǐng)務(wù)必使用 UTF-8 編碼保存文件。

格式和位置規(guī)則:

● 文件必須命名為 robots.txt。

● 網(wǎng)站只能有 1 個(gè) robots.txt 文件。

● robots.txt 文件必須位于其要應(yīng)用到的網(wǎng)站主機(jī)的根目錄下。例如,若要控制對(duì) https://www.example.com/ 下所有網(wǎng)址的抓取,就必須將 robots.txt 文件放在 https://www.example.com/robots.txt 下,一定不能將其放在子目錄中(例如 https://example.com/pages/robots.txt 下)。如果您不確定如何訪問(wèn)自己的網(wǎng)站根目錄,或者需要相應(yīng)權(quán)限才能訪問(wèn),請(qǐng)與網(wǎng)站托管服務(wù)提供商聯(lián)系。如果您無(wú)法訪問(wèn)網(wǎng)站根目錄,請(qǐng)改用其他屏蔽方法(例如元標(biāo)記)。

● robots.txt 文件可應(yīng)用到子網(wǎng)域(例如 https://website.example.com/robots.txt)或非標(biāo)準(zhǔn)端口(例如 http://example.com:8181/robots.txt)。

● robots.txt 文件必須是采用 UTF-8 編碼(包括 ASCII)的文本文件。Google 可能會(huì)忽略不屬于 UTF-8 范圍的字符,從而可能會(huì)導(dǎo)致 robots.txt 規(guī)則無(wú)效。

向 robots.txt 文件添加規(guī)則

規(guī)則是關(guān)于抓取工具可以抓取網(wǎng)站哪些部分的說(shuō)明。向 robots.txt 文件中添加規(guī)則時(shí),請(qǐng)遵循以下準(zhǔn)則:

● robots.txt 文件包含一個(gè)或多個(gè)組。

● 每個(gè)組由多條規(guī)則或指令(命令)組成,每條指令各占一行。每個(gè)組都以 User-agent 行開(kāi)頭,該行指定了組適用的目標(biāo)。

● 每個(gè)組包含以下信息:

* 組的適用對(duì)象(用戶代理)

* 代理可以訪問(wèn)的目錄或文件。

* 代理無(wú)法訪問(wèn)的目錄或文件。

● 抓取工具會(huì)按從上到下的順序處理組。一個(gè)用戶代理只能匹配 1 個(gè)規(guī)則集(即與相應(yīng)用戶代理匹配的比較早的最具體組)。

● 系統(tǒng)的默認(rèn)假設(shè)是:用戶代理可以抓取所有未被 disallow 規(guī)則屏蔽的網(wǎng)頁(yè)或目錄。

● 規(guī)則區(qū)分大小寫(xiě)。例如,disallow: /file.asp 適用于 https://www.example.com/file.asp,但不適用于 https://www.example.com/FILE.asp。

● # 字符表示注釋的開(kāi)始處。

Google 的抓取工具支持 robots.txt 文件中的以下指令:

● user-agent: [必需,每個(gè)組需含一個(gè)或多個(gè) User-agent 條目] 該指令指定了規(guī)則適用的自動(dòng)客戶端(即搜索引擎抓取工具)的名稱(chēng)。這是每個(gè)規(guī)則組的首行內(nèi)容。Google 用戶代理列表中列出了 Google 用戶代理名稱(chēng)。 使用星號(hào) (*) 會(huì)匹配除各種 AdsBot 抓取工具之外的所有抓取工具,AdsBot 抓取工具必須明確指定。例如:

# Example 1: Block only Googlebot

User-agent: Googlebot

Disallow: /

# Example 2: Block Googlebot and Ad***ot

User-agent: Googlebot

User-agent: AdsBot-Google

Disallow: /

# Example 3: Block all but AdsBot crawlers

User-agent: *

Disallow: /

● disallow: [每條規(guī)則需含至少一個(gè)或多個(gè) disallow 或 allow 條目] 您不希望用戶代理抓取的目錄或網(wǎng)頁(yè)(相對(duì)于根網(wǎng)域而言)。如果規(guī)則引用了某個(gè)網(wǎng)頁(yè),則必須提供瀏覽器中顯示的完整網(wǎng)頁(yè)名稱(chēng)。它必須以 / 字符開(kāi)頭;如果它引用了某個(gè)目錄,則必須以 / 標(biāo)記結(jié)尾。

● allow: [每條規(guī)則需含至少一個(gè)或多個(gè) disallow 或 allow 條目] 上文中提到的用戶代理可以抓取的目錄或網(wǎng)頁(yè)(相對(duì)于根網(wǎng)域而言)。此指令用于替換 disallow 指令,從而允許抓取已禁止訪問(wèn)的目錄中的子目錄或網(wǎng)頁(yè)。對(duì)于單個(gè)網(wǎng)頁(yè),請(qǐng)指定瀏覽器中顯示的完整網(wǎng)頁(yè)名稱(chēng)。對(duì)于目錄,請(qǐng)用 / 標(biāo)記結(jié)束規(guī)則。

● sitemap: [可選,每個(gè)文件可含零個(gè)或多個(gè) sitemap 條目] 相應(yīng)網(wǎng)站的站點(diǎn)地圖的位置。站點(diǎn)地圖網(wǎng)址必須是完全限定的網(wǎng)址;Google 不會(huì)假定存在或檢查是否存在 http、https、www、非 www 網(wǎng)址變體。站點(diǎn)地圖是一種用于指示 Google 應(yīng)抓取哪些內(nèi)容的理想方式,但并不用于指示 Google 可以抓取或不能抓取哪些內(nèi)容。詳細(xì)了解站點(diǎn)地圖。 示例:

Sitemap: https://example.com/sitemap.xml

Sitemap: http://www.example.com/sitemap.xml

除 sitemap 之外的所有指令都支持使用通配符 * 表示路徑前綴、后綴或整個(gè)字符串。

與這些指令均不匹配的行將被忽略。

如需有關(guān)每個(gè)指令的完整說(shuō)明,請(qǐng)參閱 Google 對(duì) robots.txt 規(guī)范的解釋頁(yè)面。

上傳 robots.txt 文件

將 robots.txt 文件保存到計(jì)算機(jī)后,您便可以將其提供給搜索引擎抓取工具。沒(méi)有一個(gè)統(tǒng)一工具可以幫助您完成這項(xiàng)工作,因?yàn)槿绾螌?robots.txt 文件上傳到網(wǎng)站取決于您的網(wǎng)站和服務(wù)器架構(gòu)。請(qǐng)與您的托管公司聯(lián)系,或在托管公司的文檔中進(jìn)行搜索;例如,搜索"上傳文件 infomaniak"。

上傳 robots.txt 文件后,請(qǐng)測(cè)試該文件是否可公開(kāi)訪問(wèn),以及 Google 能否解析該文件。

測(cè)試 robots.txt 標(biāo)記

要測(cè)試新上傳的 robots.txt 文件是否可公開(kāi)訪問(wèn),請(qǐng)?jiān)跒g覽器中打開(kāi)無(wú)痕瀏覽窗口(或等效窗口),然后轉(zhuǎn)到 robots.txt 文件的位置。例如:https://example.com/robots.txt。如果您看到 robots.txt 文件的內(nèi)容,就可準(zhǔn)備測(cè)試標(biāo)記了。

Google 提供了兩種測(cè)試 robots.txt 標(biāo)記的方式:

1、Search Console 中的 robots.txt 測(cè)試工具。您只能針對(duì)您網(wǎng)站上可供訪問(wèn)的 robots.txt 文件使用此工具。

2、如果您是開(kāi)發(fā)者,請(qǐng)了解并構(gòu)建 Google 的開(kāi)源 robots.txt 庫(kù),該庫(kù)也用在 Google 搜索中。您可以使用此工具在計(jì)算機(jī)上本地測(cè)試 robots.txt 文件。

向 Google 提交 robots.txt 文件

在您上傳并測(cè)試 robots.txt 文件后,Google 的抓取工具會(huì)自動(dòng)找到并開(kāi)始使用您的 robots.txt 文件。您無(wú)需采取任何操作。如果您更新了 robots.txt 文件,并需要盡快刷新 Google 的緩存副本,請(qǐng)了解如何提交更新后的 robots.txt 文件。

實(shí)用的 robots.txt 規(guī)則

下面是一些常見(jiàn)的實(shí)用 robots.txt 規(guī)則:

實(shí)用規(guī)則禁止抓取整個(gè)網(wǎng)站請(qǐng)注意,在某些情況下,Google 即使未抓取網(wǎng)站的網(wǎng)址,仍可能將其編入索引。注意:這不適用于各種 AdsBot 抓取工具,此類(lèi)抓取工具必須明確指定。

User-agent: *

Disallow: /禁止抓取某一目錄及其內(nèi)容在目錄名后添加一道正斜線,即可禁止抓取整個(gè)目錄。禁止抓取的目錄字符串可以出現(xiàn)在路徑中的任何位置,因此 Disallow: /junk/ 與 https://example.com/junk/ 和 https://example.com/for-sale/other/junk/ 均匹配。

注意:請(qǐng)勿使用 robots.txt 禁止訪問(wèn)私密內(nèi)容;請(qǐng)改用正確的身份驗(yàn)證機(jī)制。對(duì)于 robots.txt 文件所禁止抓取的網(wǎng)址,Google 仍可能會(huì)在不進(jìn)行抓取的情況下將其編入索引;另外,由于 robots.txt 文件可供任何人隨意查看,因此可能會(huì)泄露您的私密內(nèi)容的位置。

User-agent: *

Disallow: /calendar/

Disallow: /junk/

Disallow: /books/fiction/contemporary/

僅允許某一抓取工具訪問(wèn)網(wǎng)站內(nèi)容只有 googlebot-news 可以抓取整個(gè)網(wǎng)站。

User-agent: Googlebot-news

Allow: /

User-agent: *

Disallow: /允許除某一抓取工具以外的其他所有抓取工具訪問(wèn)網(wǎng)站內(nèi)容Unnecessarybot 不能抓取相應(yīng)網(wǎng)站,所有其他漫游器都可以。

User-agent: Unnecessarybot

Disallow: /

User-agent: *

Allow: /禁止抓取某一網(wǎng)頁(yè)例如,禁止抓取 useless_file.Html 網(wǎng)頁(yè)。

User-agent: *

Disallow: /useless_file.html禁止 Google 圖片訪問(wèn)某一特定圖片例如,禁止訪問(wèn) dogs.jpg 圖片。

User-agent: Googlebot-Image

Disallow: /images/dogs.jpg禁止 Google 圖片訪問(wèn)您網(wǎng)站上的所有圖片如果無(wú)法抓取圖片和視頻,則 Google 無(wú)法將其編入索引。

User-agent: Googlebot-Image

Disallow: /

禁止抓取某一特定文件類(lèi)型的文件例如,禁止抓取所有 .gif 文件。

User-agent: Googlebot

Disallow: /*.gif$禁止抓取整個(gè)網(wǎng)站,但允許 Mediapartners-Google 訪問(wèn)內(nèi)容實(shí)施此規(guī)則會(huì)阻止您的網(wǎng)頁(yè)顯示在搜索結(jié)果中,但 Mediapartners-Google 網(wǎng)頁(yè)抓取工具仍能分析這些網(wǎng)頁(yè),以確定要向訪問(wèn)您網(wǎng)站的用戶顯示哪些廣告。

User-agent: *

Disallow: /

User-agent: Mediapartners-Google

Allow: /使用 $ 匹配以特定字符串結(jié)尾的網(wǎng)址例如,禁止抓取所有 .xls 文件。

User-agent: Googlebot

Disallow: /*.xls$

TAG:谷歌搜索引擎怎么優(yōu)化

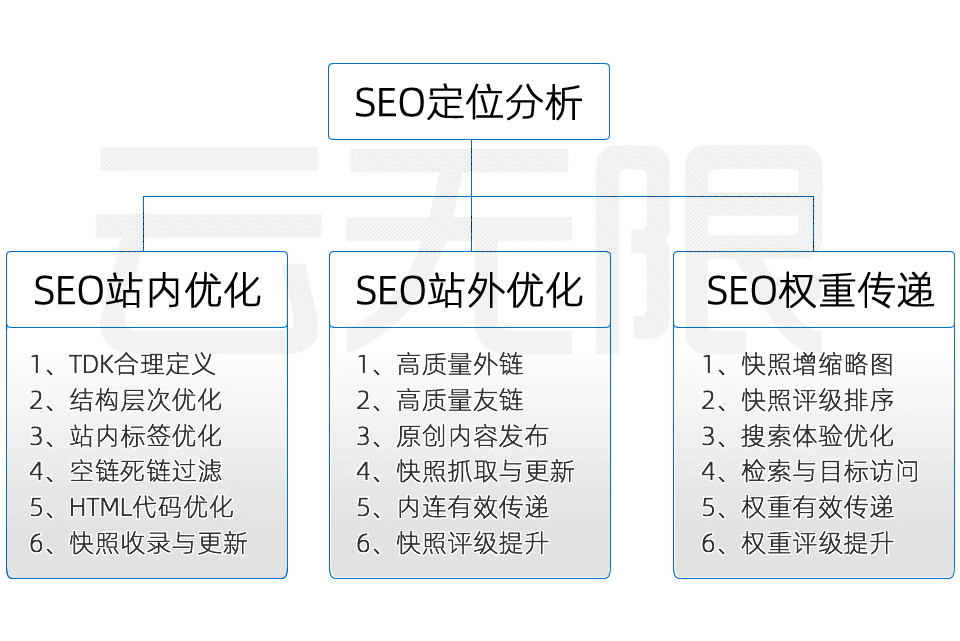

SEO就是搜索引擎優(yōu)化:讓你的網(wǎng)站在搜索引擎(比如百度、谷歌)的排名更靠前,當(dāng)用戶通過(guò)關(guān)鍵詞搜索時(shí)更容易搜到你的網(wǎng)站,從而實(shí)現(xiàn)企業(yè)品牌曝光、主動(dòng)獲客和營(yíng)銷(xiāo)推廣的目標(biāo)。為什么要做SEO?

提高網(wǎng)站訪問(wèn)量:SEO能讓你的網(wǎng)站在搜索引擎結(jié)果中更靠前,吸引更多客戶點(diǎn)擊。

降低市場(chǎng)營(yíng)銷(xiāo)成本:相比于付費(fèi)廣告,SEO是一種更經(jīng)濟(jì)有效的營(yíng)銷(xiāo)方式。

提升品牌知名度:網(wǎng)站排名靠前,可以讓更多用戶看到你的品牌名稱(chēng)和信息,增強(qiáng)品牌影響力。

SEO優(yōu)化有哪些優(yōu)勢(shì)?

SEO優(yōu)化有哪些優(yōu)勢(shì)?成本低廉:主要成本是優(yōu)化師的工資。

效果穩(wěn)定:一旦網(wǎng)站排名上升,效果穩(wěn)定持久,可持續(xù)獲得展現(xiàn)機(jī)會(huì)。

不受地域限制:SEO的效果可以覆蓋全球,不受時(shí)間和空間的限制。

什么樣的公司更適合做SEO優(yōu)化呢?大多數(shù)行業(yè)都可以從SEO中受益。特別是那些希望用戶主動(dòng)訪問(wèn)我們的網(wǎng)站、降低營(yíng)銷(xiāo)成本、提升品牌知名度的企業(yè)。通過(guò)SEO來(lái)優(yōu)化自己的網(wǎng)站,可吸引更多潛在客戶。

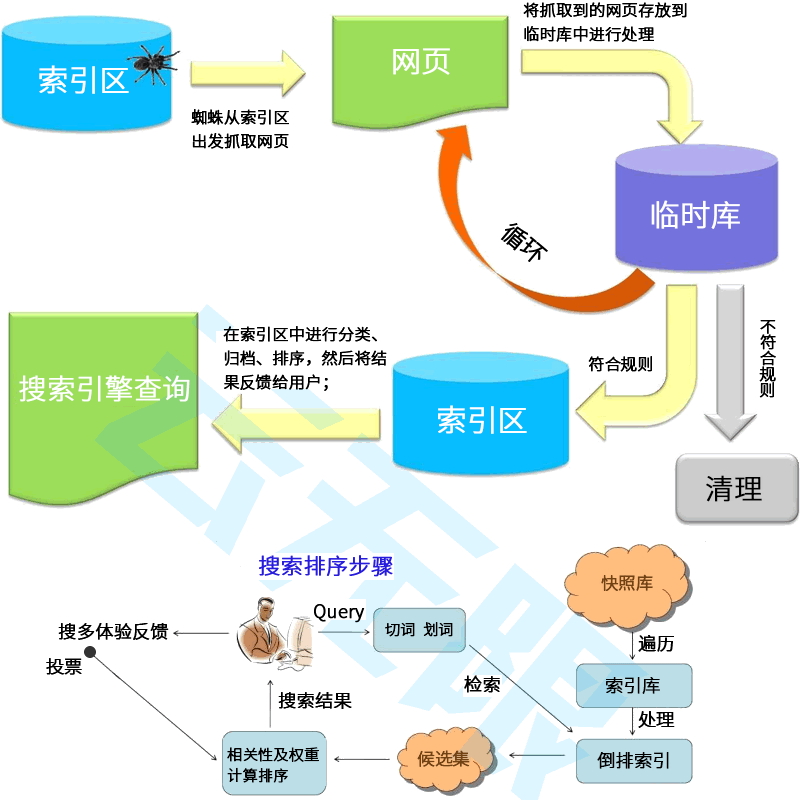

SEO是一種工人的有效的網(wǎng)絡(luò)營(yíng)銷(xiāo)手段,可以幫助企業(yè)提升關(guān)鍵詞排名,吸引更多用戶,實(shí)現(xiàn)商業(yè)目標(biāo)。SEO是一個(gè)長(zhǎng)期且專(zhuān)業(yè)的技術(shù),企業(yè)在進(jìn)行SEO時(shí),必須耐心優(yōu)化,因?yàn)镾EO涉及到的不止是網(wǎng)站結(jié)構(gòu)、內(nèi)容質(zhì)量、用戶體驗(yàn)、外部鏈接這幾個(gè)方面;還有算法的更替、蜘蛛的引導(dǎo)、快照的更新、參與排序的權(quán)重等。

SEO策略

搜到你

讓用戶搜到你的網(wǎng)站是做SEO優(yōu)化的目標(biāo),擁有精湛的SEO技術(shù)、豐富的經(jīng)驗(yàn)技巧以及對(duì)SEO規(guī)則的深刻把握才有機(jī)會(huì)獲得更好排名!

了解你

確保網(wǎng)站內(nèi)容清晰、準(zhǔn)確、易于理解,使用戶能夠輕松找到所需信息.使用簡(jiǎn)潔明了的標(biāo)題和描述,幫助用戶快速了解你的產(chǎn)品服務(wù)!

信任你

將企業(yè)的核心價(jià)值、差異化賣(mài)點(diǎn)、吸引眼球的宣傳語(yǔ)等品牌詞盡可能多的占位搜索前幾頁(yè),增強(qiáng)用戶印象,優(yōu)化用戶體驗(yàn)讓訪客信任你!

選擇你

優(yōu)化落地頁(yè)引導(dǎo)用戶咨詢或預(yù)約留言,引用大型案例或權(quán)威報(bào)道彰顯品牌實(shí)力,關(guān)注用戶需求和反饋,不斷優(yōu)化產(chǎn)品服務(wù)讓用戶選擇你!

關(guān)鍵詞研究

品牌關(guān)鍵詞

提升品牌知名度、塑造品牌形象,吸引對(duì)品牌感興趣的用戶,同時(shí)幫助監(jiān)測(cè)品牌在搜索引擎中的表現(xiàn)。

核心關(guān)鍵詞

是網(wǎng)站內(nèi)容的主要焦點(diǎn),能吸引大量目標(biāo)受眾,提高網(wǎng)站在相關(guān)搜索中的排名。搜索量大,競(jìng)爭(zhēng)較激烈。

長(zhǎng)尾關(guān)鍵詞

更能夠更精確地定位目標(biāo)受眾,提高轉(zhuǎn)化率,競(jìng)爭(zhēng)相對(duì)較小更容易獲得排名,更符合用戶的具體搜索意圖。

區(qū)域關(guān)鍵詞

針對(duì)特定地區(qū)進(jìn)行優(yōu)化,幫助本地企業(yè)吸引當(dāng)?shù)赜脩簦岣弑镜厥袌?chǎng)的曝光度。適用于有地域性需求的企業(yè)。

競(jìng)品關(guān)鍵詞

與競(jìng)爭(zhēng)對(duì)手品牌或產(chǎn)品相關(guān)的詞,通過(guò)分析這些關(guān)鍵詞,可以了解競(jìng)爭(zhēng)對(duì)手的優(yōu)勢(shì)和劣勢(shì)。

產(chǎn)品關(guān)鍵詞

直接針對(duì)產(chǎn)品進(jìn)行優(yōu)化,與具體產(chǎn)品或服務(wù)直接相關(guān),如產(chǎn)品名稱(chēng)、型號(hào)、功能等描述性詞匯。

搜索下拉詞

反映用戶的搜索習(xí)慣和需求,是搜索引擎根據(jù)用戶輸入自動(dòng)推薦的詞匯,與用戶搜索意圖高度相關(guān)。

相關(guān)搜索詞

提供與主題相關(guān)的其他搜索詞匯,幫助用戶發(fā)現(xiàn)更多相關(guān)內(nèi)容,同時(shí)擴(kuò)展網(wǎng)站的優(yōu)化范圍。

站內(nèi)SEO

TDK優(yōu)化

力爭(zhēng)一次性完成網(wǎng)站頁(yè)面標(biāo)題、描述、關(guān)鍵詞的的合理部署

鏈接優(yōu)化

包含LOGO鏈接、導(dǎo)航鏈接、文章鏈接及外部鏈接等SEO優(yōu)化設(shè)置

HTML優(yōu)化

HTML代碼、標(biāo)簽等優(yōu)化:H,alt,strong,title,span,title等標(biāo)簽

內(nèi)容優(yōu)化

固定內(nèi)容與關(guān)鍵詞SEO匹配、動(dòng)態(tài)內(nèi)容提升蜘蛛抓取率增強(qiáng)快照評(píng)級(jí)

站外SEO

1)降低文章內(nèi)容在搜索結(jié)果的重合度。尤其是文章標(biāo)題、段落主題、內(nèi)容摘要等;

2)標(biāo)題包含關(guān)鍵詞(可包含部分或完整匹配)字?jǐn)?shù)控制在24字內(nèi);

3)提煉的文章概要(100字內(nèi))必須與關(guān)鍵詞有相關(guān)性才有意義;

4)新文章不要增加錨文本超鏈接,等文章快照有排名后再擴(kuò)充錨文本鏈接;

5)文章內(nèi)容與標(biāo)題關(guān)鍵詞相呼應(yīng),建立關(guān)聯(lián),也可根據(jù)關(guān)鍵詞擴(kuò)充有關(guān)的內(nèi)容;

6)文章中的圖片最好增加alt屬性,圖片不要失真和變形,寬度大于500px更優(yōu)機(jī)會(huì)搶占搜索快照縮略圖;

7)文章排版合理、段落分明、段落主題用H標(biāo)簽加強(qiáng),段落內(nèi)容用span或p標(biāo)簽區(qū)分;

8)發(fā)布文章后先引導(dǎo)收錄。如提交搜索引擎登錄、合理使用有排名快照的內(nèi)部鏈接;

9)如果文章7天還沒(méi)有收錄,就要提升文章內(nèi)容質(zhì)量再發(fā)布;

關(guān)鍵詞快照優(yōu)化

增加快照縮略圖

增加搜索左側(cè)縮略圖、增強(qiáng)搜索標(biāo)題的醒目性、增加搜索簡(jiǎn)要內(nèi)容的有效性...

快照相關(guān)性分析

通過(guò)site指令找到排名不理想的快照,提升內(nèi)容相關(guān)性、增強(qiáng)關(guān)鍵詞索引快照...

展現(xiàn)與點(diǎn)擊分析

哪些詞展現(xiàn)而沒(méi)有被點(diǎn)擊?哪些關(guān)鍵詞被用戶點(diǎn)擊了,如何增強(qiáng)有效點(diǎn)擊率?

訪客來(lái)路分析

哪些地區(qū)用戶訪問(wèn)最多?訪問(wèn)了什么頁(yè)面?有效轉(zhuǎn)化如何?建立精準(zhǔn)的用戶畫(huà)像...

SEO優(yōu)化

SEO優(yōu)化 搜索引擎SEO

搜索引擎SEO  自然流量

自然流量